Google如何识别PBN网络?Link Graph算法与站群识别机制

2026年3月4日,Google 在 Search Central 文档中做了一次非常有象征意义的更新:

删除了 […]

在SEO历史上,外链(Backlinks)曾被视为最强排名因素。

早期搜索算法依赖 PageRank,即:

一个网页被多少网页链接,以及这些网页的权威度。

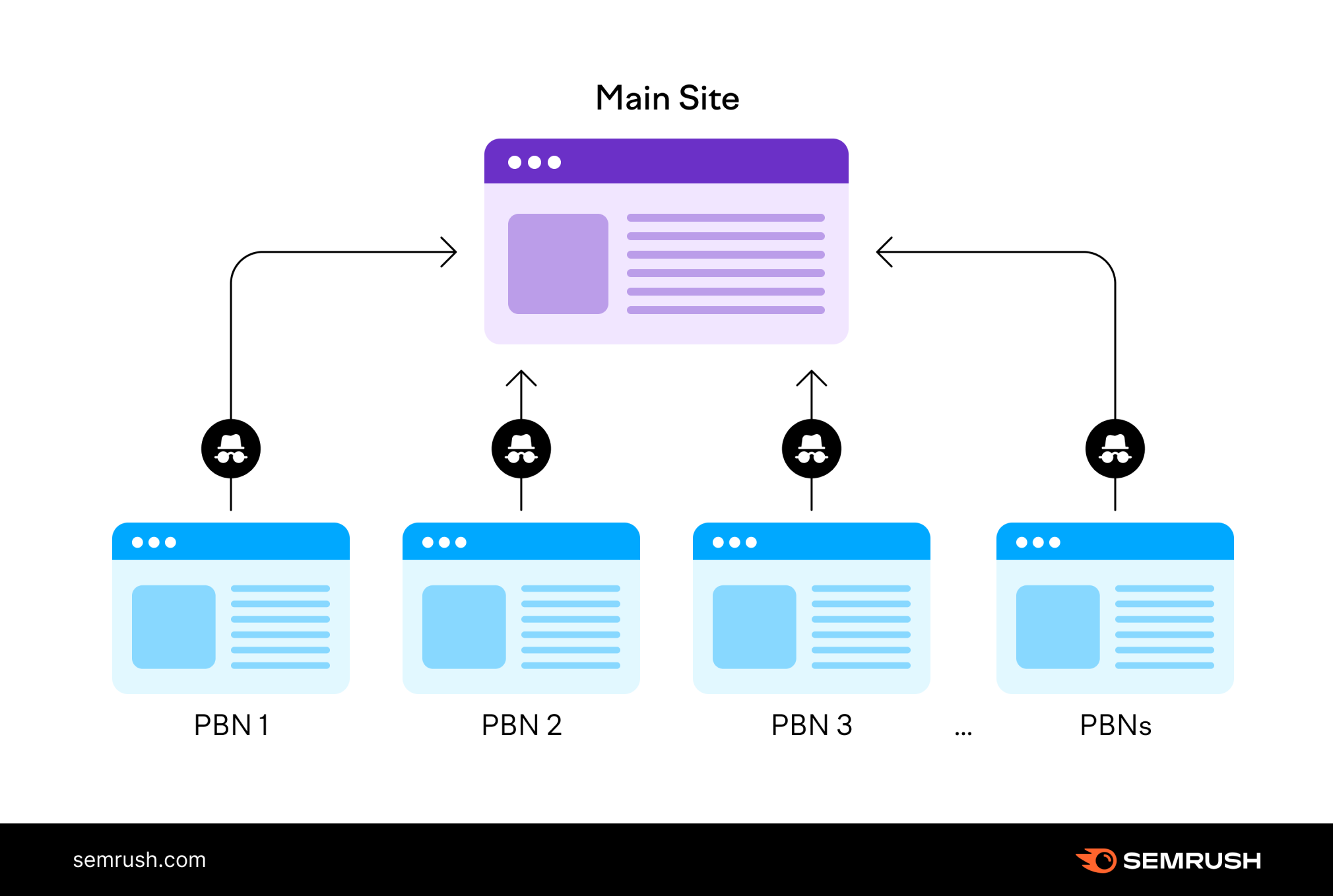

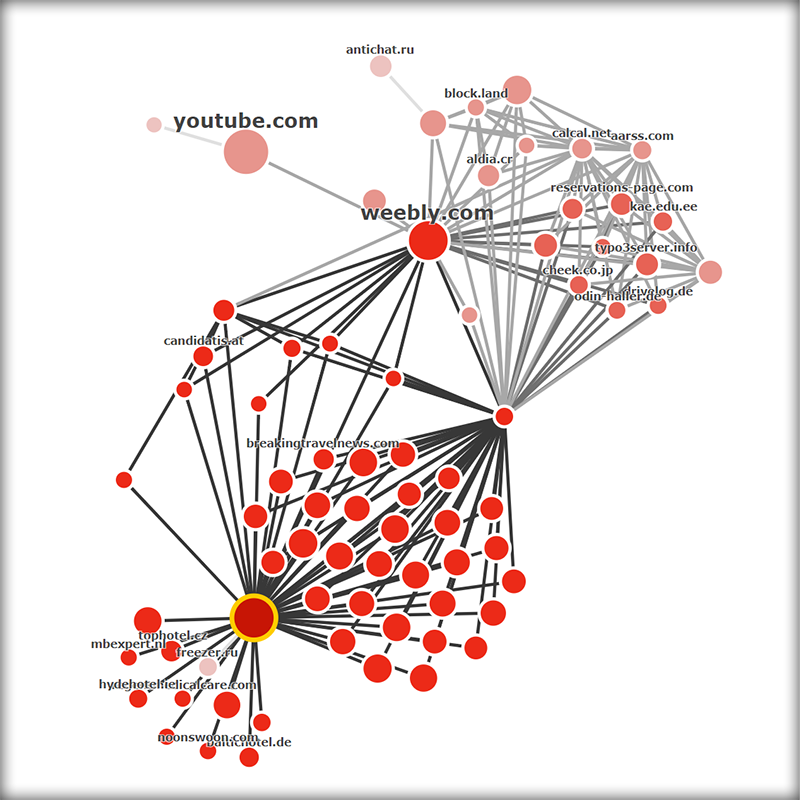

然而随着SEO行业的快速发展,大量人为操纵链接的行为出现:

在Google的排序体系中,一个常被忽视但极其重要的现象是:

局部低质量内容,可能影响整站排名。

很多网站运营者误以为:

但在现代搜索算法体系中,这种认知往往是错误的。

哪怕:

低质量内容仅占全站页面的 20% 以下

也可能触发:

SEO + 安全合规系列合集

当我们再次回到这个关键词:

how to make French toast

Google 已经拥有成千上万篇内容。那么问题来了:

为什么某些网站几乎“天然具备排名资格”?

为什么有些站点哪怕内容并不独特,也能获得可观位置?

这就进入今天的核心主题——Authority […]

在大多数SEO策略中,我们习惯思考“排名因子”。

但在Google的系统层面,它思考的是:

如何在不确定的用户意图下,最大化整体满意度?

这就是“内容多样性(Content Diversity)”存在的意义。

它不是锦上添花,而是搜索质量控制的核心机制之一。

以关键词 “jaguar” 为例。

它可以指:

在过去几年中,围绕 核心算法更新(Broad Core Updates)、Helpful Content […]