在技术SEO中,抓取(Crawling)网站核心内容是提升网站搜索引擎排名的关键。Robots.txt 文件是管理爬虫行为的重要工具,合理使用它可以引导搜索引擎集中资源抓取对SEO有价值的页面,避免浪费抓取预算在无用或重复页面上。本文将分享如何利用Robots.txt 文件抓取网站核心内容的最佳实践,帮助SEO从业者和站长优化搜索引擎的抓取效率和效果。

1. 理解抓取预算与其重要性

在深入讨论 Robots.txt 文件最佳实践之前,首先要了解抓取预算的概念。抓取预算(Crawl Budget) 是搜索引擎在特定时间内分配给一个网站的抓取量。抓取预算取决于以下几个因素:

- 网站大小:页面越多,抓取预算越大。

- 网站更新频率:更新越频繁,爬虫访问越频繁。

- 服务器性能:服务器能否高效响应爬虫请求影响抓取预算的分配。

抓取预算并非无限,特别是对于大型网站来说,优化抓取预算至关重要。通过合理的 Robots.txt 文件设置,可以引导爬虫抓取对SEO最有价值的页面,避免无关页面占用抓取预算。

2. Robots.txt 文件的作用

Robots.txt 文件 是一个位于网站根目录的文本文件,用于告诉搜索引擎爬虫哪些页面允许抓取,哪些页面应避免抓取。合理设置 Robots.txt 文件不仅可以提升搜索引擎的抓取效率,还可以保护不希望公开的内容或节省服务器资源。

在优化抓取网站核心内容时,Robots.txt 文件的主要作用包括:

- 允许爬虫抓取重要内容:确保搜索引擎可以抓取和索引对SEO至关重要的页面,如首页、产品页、博客内容等。

- 禁止无价值页面的抓取:避免爬虫抓取后台管理页面、隐私政策、购物车页面等无SEO价值的页面,节省抓取预算。

- 避免重复内容问题:通过禁止抓取重复内容或类似内容的页面,防止搜索引擎因重复内容对网站排名做出负面评价。

3. 抓取核心内容的最佳实践

3.1 确保重要内容对爬虫可见

核心内容通常是指那些与用户需求和业务目标密切相关的页面,包括:

- 首页:网站的首页通常是流量的主要入口,必须保证它对爬虫完全开放。

- 产品和服务页面:电商或服务类网站的产品或服务页面通常是核心内容,确保它们被正确抓取和索引至关重要。

- 博客和内容页面:原创内容对于提升排名至关重要,确保所有有价值的博客文章和资讯页面能被搜索引擎抓取。

最佳实践:确保核心目录可抓取

在 Robots.txt 文件中明确允许爬虫抓取包含核心内容的目录和页面,并定期审查这些路径的设置是否与实际页面相符。

3.2 禁止抓取无价值页面

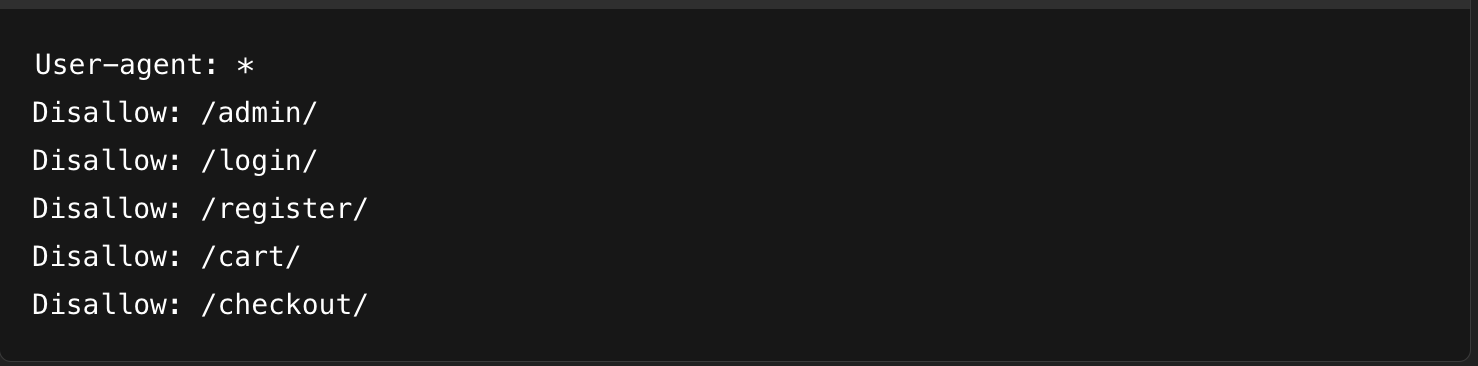

搜索引擎爬虫的抓取时间和预算有限,应尽量避免让它们浪费资源在无关紧要的页面上。以下类型的页面通常不需要抓取:

- 后台管理页面:如

/admin/、/wp-admin/等,这类页面对用户和SEO没有价值,应明确禁止。 - 购物车和结账页面:如

/cart/和/checkout/,这些页面不应被索引,因为它们通常会生成动态内容,对SEO无助。 - 登录和注册页面:如

/login/和/register/,这些页面主要用于用户操作,与SEO无关。

最佳实践:禁止抓取无价值页面

这样可以有效节省抓取预算,将资源集中在对SEO有帮助的页面上。

3.3 避免重复内容抓取

重复内容会稀释SEO效果,导致多个页面相互竞争排名,影响整体权重。为了避免重复内容问题,Robots.txt 可以用来禁止爬虫抓取某些动态或参数化URL,例如:

- 过滤器和排序功能:许多电商网站允许用户根据价格、颜色、分类等条件筛选商品,这些筛选功能会生成带有参数的URL,如

?sort=price_asc。这些页面通常没有独特的SEO价值,应该禁止抓取。 - 标签页面:博客或内容型网站的标签页面(如

/tag/或/category/)有时会导致大量重复内容,应该限制这些页面的抓取。

最佳实践:禁止抓取参数化URL和重复页面

使用通配符 * 和 ? 符号,精确定位并禁止抓取那些会造成重复内容的问题页面。

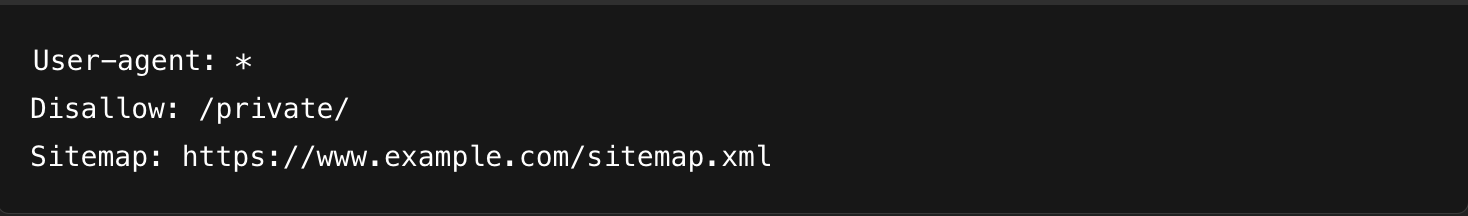

3.4 提供优先级内容提示

虽然 Robots.txt 文件可以帮助限制不必要的抓取,但同时也可以通过 Sitemap 文件告知搜索引擎哪些内容最为重要。向 Robots.txt 中添加 Sitemap 的路径,有助于搜索引擎更高效地抓取网站。

最佳实践:在Robots.txt中包含 Sitemap 路径

Sitemap 是包含网站所有重要页面的索引文件,向搜索引擎展示网站结构,帮助它们更全面和优先地抓取关键内容。

3.5 细化抓取规则

有时,特定目录下的某些页面是核心内容,而其他页面则可以禁止抓取。使用 Robots.txt 的 Allow 和 Disallow 组合规则可以对同一目录内的不同页面进行细化控制。例如,允许爬虫抓取博客中的热门文章,而禁止其抓取归档页面。

最佳实践:细化抓取规则

这种方式能够确保爬虫只抓取核心内容,而避免低质量或无关页面占用抓取预算。

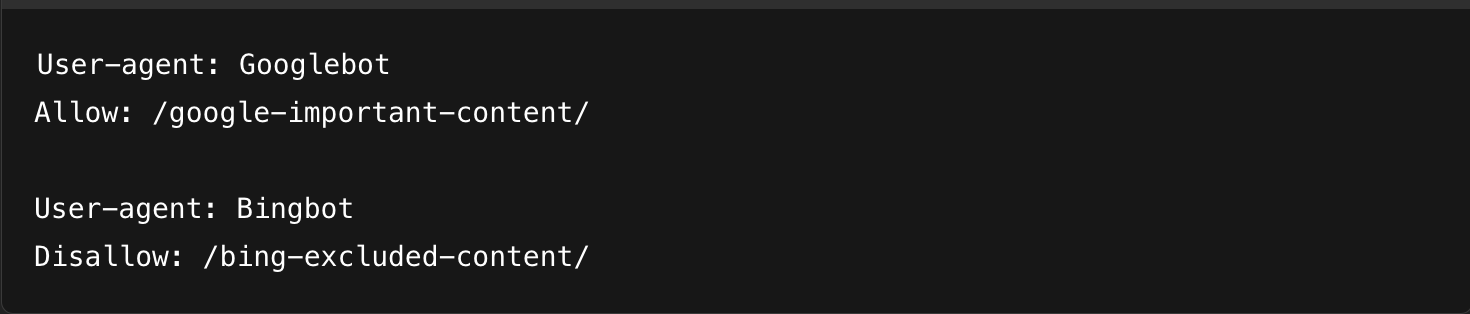

3.6 针对不同爬虫设置不同规则

并非所有爬虫都对网站有同样的抓取需求。谷歌爬虫(Googlebot)和必应爬虫(Bingbot)可能有不同的访问策略。在某些情况下,你可以为不同的搜索引擎设定不同的抓取规则,以适应它们的需求或策略。

最佳实践:为不同爬虫设置不同规则

这种做法有助于为不同的搜索引擎优化抓取行为,从而提升全站的SEO效果。

3.7 定期检查与优化

即使你的Robots.txt文件已经正确设置,也应定期监控和优化其配置。使用谷歌的 Search Console 提供的 Robots.txt 测试工具 来检查文件的正确性,确保爬虫能够抓取正确的内容,并排除错误配置。此外,分析搜索引擎抓取日志可以帮助发现爬虫的抓取行为是否符合预期。

- Robots.txt 测试工具:谷歌提供的工具可以帮助站长检测 Robots.txt 文件的配置,并验证是否有误阻爬问题。

- 抓取日志分析:使用抓取日志分析工具,查看搜索引擎实际抓取了哪些页面,是否有未抓取的核心内容或不必要的抓取行为。

结语

Robots.txt 文件是技术SEO的重要工具,通过合理配置可以有效管理爬虫行为,确保抓取预算集中在网站核心内容上,避免无用页面浪费爬虫资源。为了实现最佳SEO效果,网站管理员和SEO从业者应结合抓取预算的概念,使用细化的抓取规则、优化重复内容抓取,并合理利用Sitemap 指导爬虫抓取重要页面。

通过遵循这些最佳实践,站长可以确保搜索引擎高效抓取对SEO有价值的页面,从而提升网站的搜索引擎可见性和整体排名。

最近文章

如何判断站点是否已经进入系统依赖阶段 在 AI 搜索环境中,站点的发展存在一个重要分水岭。 [...]

整站内容如何形成长期不可替代性 在 AI 搜索时代,“不可替代性”已经不再是一个抽象的品牌概念。 [...]

如何设计整站级的答案供给架构 当内容开始被 AI 使用,站点面临的已经不再是排名问题,而是一个更本质的问题: [...]