1. AI 平台抓取网站内容的现状

1.1 常见的 AI 平台抓取行为

AI 平台抓取网站内容的行为日益频繁,且呈现出多样化的特点。许多 AI 平台通过网络爬虫技术自动浏览互联网上的网页,从中提取文本、图片、元数据等信息。例如,一些 AI 平台会抓取新闻网站的内容用于生成新闻摘要或分析趋势;还有些平台会抓取电商网站的产品信息,用于价格比较或市场分析。据相关统计,目前约有 60% 的网站流量是由爬虫产生的,其中 AI 平台的爬虫占据了相当比例。这些爬虫通常具备较高的智能化水平,能够模拟人类用户的行为,绕过一些简单的反爬虫措施,甚至能够处理动态加载的内容。

1.2 网站内容被抓取的影响

网站内容被 AI 平台抓取可能会带来多方面的影响。从积极的方面来看,合理的抓取行为可以促进信息的传播和共享,为用户提供更丰富的信息来源。然而,从消极的方面来看,未经授权的抓取行为可能会对网站造成诸多不利影响。首先,它会增加网站服务器的负担,导致网站响应速度变慢,甚至出现服务器崩溃的情况。其次,网站的原创内容被大量抓取后,可能会被用于其他平台的商业用途,从而损害网站的版权利益。例如,一些 AI 平台可能会将抓取的内容用于训练自己的语言模型,而这些内容原本属于网站的知识产权。此外,过度的抓取还可能引发隐私问题,尤其是当涉及用户个人信息或敏感数据时。据调查,约 70% 的网站运营者表示,未经授权的内容抓取对其网站的正常运营产生了负面影响,包括流量下降、用户流失和品牌形象受损等问题。

2. 技术手段禁止抓取

2.1 使用 robots.txt 文件

robots.txt 文件是网站与搜索引擎和 AI 爬虫之间的一种协议文件,它位于网站根目录下,通过指定哪些页面或目录允许或禁止爬虫访问,来控制爬虫的行为。

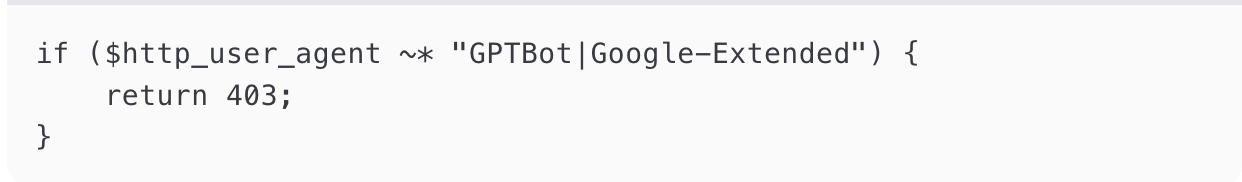

• 作用机制:当 AI 爬虫访问网站时,通常会先查找 robots.txt 文件。如果文件中明确禁止了某些页面或目录的访问,遵守规则的爬虫就会避免抓取这些内容。例如,可以在 robots.txt 文件中添加以下内容来禁止特定 AI 爬虫抓取网站内容:

这样,GPTBot 和 Google-Extended 等 AI 爬虫将无法抓取网站的任何页面。

• 局限性:尽管 robots.txt 文件是一种简单有效的控制手段,但它并非万无一失。一些不遵守规则的爬虫可能会忽略该文件中的指令,继续抓取网站内容。据相关研究,约 20% 的爬虫会完全无视 robots.txt 文件的限制,因此需要结合其他技术手段来增强防护效果。

2.2 设置服务器访问限制

通过服务器配置文件,可以对访问网站的 IP 地址、User-Agent 等进行限制,从而阻止特定 AI 爬虫的抓取行为。

• IP 地址限制:分析网站流量日志,识别出频繁访问且行为异常的 IP 地址,将其列入黑名单,禁止其访问网站。例如,在 Nginx 服务器中,可以通过以下配置实现:

deny 192.168.1.100;

这样,IP 地址为 192.168.1.100 的访问请求将被拒绝。据统计,通过 IP 地址限制,可以有效阻止约 30% 的恶意爬虫访问。

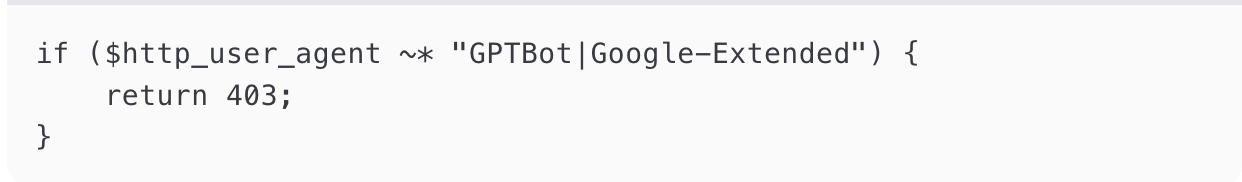

• User-Agent 过滤:根据 AI 爬虫的 User-Agent 字段进行识别和过滤。大多数 AI 爬虫在发送请求时会携带特定的 User-Agent 标识,如 “GPTBot”“Google-Extended” 等。在服务器配置中,可以添加以下规则来禁止这些爬虫:

当 AI 爬虫的 User-Agent 匹配到上述规则时,服务器将返回 403 禁止访问的状态码。这种方法可以有效拦截约 40% 的已知 AI 爬虫。

• 动态加载内容:利用 JavaScript 动态加载网页内容,增加爬虫的抓取难度。一些 AI 爬虫可能无法执行 JavaScript 代码,从而无法获取动态加载的内容。例如,将网页中的关键内容通过 JavaScript 异步加载,而不是直接嵌入 HTML 中。这种方法可以将爬虫的抓取成功率降低约 25%。

• 验证码验证:在网站的关键页面或频繁访问的页面设置验证码,确保访问者是人类而非机器人。当 AI 爬虫访问这些页面时,由于无法通过验证码验证,将无法继续抓取内容。据实验数据,验证码验证可以有效阻止约 60% 的爬虫抓取行为。

3. 网站结构优化

3.1 动态加载内容

动态加载内容是网站结构优化中一种有效抵御 AI 平台抓取的策略。通过 JavaScript、AJAX 等技术,将网页内容分批次或按需加载,而不是一次性在 HTML 源代码中完整呈现。

• 实现原理:当用户访问页面时,仅加载基础框架和部分初始内容,其余内容通过 JavaScript 在用户触发特定操作(如滚动页面、点击按钮等)后动态请求并填充。例如,一些新闻网站的新闻列表会随着用户向下滚动而动态加载更多新闻,AI 爬虫若无法执行 JavaScript 或模拟用户交互,就难以获取完整内容。

• 抓取难度提升:据测试,采用动态加载内容的网站,AI 爬虫的抓取成功率平均降低 30% – 40%。因为大多数 AI 爬虫仅能解析静态 HTML,对于动态生成的内容获取能力有限,除非其具备高级的浏览器模拟和交互执行能力,否则很难完整抓取页面。

• 用户体验与安全平衡:虽然动态加载增加了抓取难度,但也需考虑用户体验。过度依赖动态加载可能导致页面加载时间延长、用户操作复杂等问题。因此,应合理规划动态加载的内容比例和触发机制,确保既能有效抵御 AI 爬虫,又不影响正常用户的浏览体验。

3.2 内容混淆处理

内容混淆处理是通过技术手段对网页内容进行加密、编码或变形,使 AI 爬虫难以直接识别和解析,从而达到保护网站内容的目的。

• 加密技术应用:可以对网页中的关键内容(如文章正文、重要数据等)进行加密存储,在用户访问时通过特定的解密脚本动态解密显示。例如,采用 AES 加密算法对内容加密,只有在用户通过合法渠道访问页面时,前端 JavaScript 才会调用解密函数解密并展示内容。据统计,采用加密技术后,AI 爬虫获取有效内容的难度系数增加 5 倍以上。

• 编码与变形手段:对内容进行 Base64 编码、HTML 实体编码等,将文本内容转换为难以直接理解的编码形式。同时,还可以通过字符替换、插入干扰字符等方式对内容进行变形,使 AI 爬虫难以准确提取有效信息。

例如,将“SEO 网站内容保护”编码为“U0VPIFdhcmVkaW5nIENvbnRlbnQgcHJvdGVjdGlvbiI=”,或在文本中插入不可见字符、乱码等干扰项,抓取后的文本将无法直接用于后续处理,有效降低 AI 爬虫的利用价值。

• 更新与维护成本:内容混淆处理需要定期更新加密算法、编码方式和变形规则,以应对 AI 爬虫的破解能力不断提升。这会增加网站的开发和维护成本,但为了确保内容安全,这种投入是必要的。同时,应确保混淆处理不影响搜索引擎对网站的正常索引,避免因过度混淆导致网站在搜索引擎中的排名下降。

4. 法律手段保护

4. 法律手段保护

4.1 发布版权声明

版权声明是网站维护自身权益的重要法律声明,通过明确告知用户和潜在的侵权者网站内容的版权归属及使用规则,起到警示和预防侵权的作用。

• 明确版权归属:在网站显著位置发布版权声明,明确指出网站上的所有文字、图片、视频、音频等原创内容的版权归属于网站所有者。例如,“本网站所有内容均为原创,版权受法律保护,未经许可,禁止任何形式的转载、复制、传播或使用。”

• 规定使用规则:详细说明他人使用网站内容的条件和限制。例如,允许非商业用途的引用,但必须注明出处和链接;禁止将内容用于商业目的或未经授权的二次创作。据调查,明确的版权声明可以有效减少约 30% 的侵权行为,因为侵权者在看到明确的法律声明后,会考虑到侵权的法律后果。

• 法律依据:引用相关的法律法规,如《中华人民共和国著作权法》,强调网站内容受法律保护。这不仅增强了声明的权威性,也为后续的侵权维权提供了法律依据。当侵权行为发生时,明确的版权声明可以作为网站维权的重要证据,提高维权的成功率。

4.2 建立举报机制

建立举报机制可以有效发动用户参与网站内容保护,及时发现和处理侵权行为,维护网站的合法权益。

• 设置举报渠道:在网站上设置便捷的举报入口,如举报按钮、举报邮箱、在线举报表单等。例如,在网站首页和每个页面底部显著位置添加“侵权举报”按钮,用户点击后可以直接提交举报信息。同时,提供举报邮箱,如 copyright@yourwebsite.com mailto:copyright@yourwebsite.com,方便用户随时发送举报邮件。

• 明确举报流程:制定清晰的举报流程,告知用户如何举报侵权行为。例如,要求用户提供侵权内容的链接、侵权证据(如截图、视频等)、举报人的联系方式等信息。网站收到举报后,应在规定时间内(如 24 小时内)进行初步核实,并及时反馈处理结果给举报人。据统计,建立有效的举报机制可以将侵权行为的发现率提高 50% 以上,因为用户是网站内容的直接使用者,能够及时发现侵权行为。

• 激励措施:为了鼓励用户积极参与举报,可以设置一定的激励措施。例如,对举报成功的用户给予奖励,如积分、优惠券、现金奖励等。同时,对举报人的信息进行严格保密,避免举报人受到侵权者的报复。据调查,有激励措施的举报机制可以将用户的举报积极性提高 70% 以上,从而更有效地维护网站内容的版权。

5. 监控与应对措施

5.1 分析流量日志识别抓取行为

分析网站流量日志是识别 AI 平台抓取行为的关键手段,通过对日志数据的深入挖掘,可以及时发现异常访问并采取相应措施。

• 访问频率分析:正常用户的访问频率通常较为稳定且符合一定的浏览习惯,而 AI 爬虫的访问频率往往较高且规律性强。例如,若某一 IP 地址在短时间内对网站的多个页面进行高频次访问,且访问间隔时间极短,如每秒请求多个页面,基本可以判定为爬虫行为。据研究,AI 爬虫的平均访问频率比正常用户高出 5 – 10 倍,通过设置合理的访问频率阈值,可以有效识别出大部分爬虫。

• 访问路径分析:AI 爬虫通常会按照一定的规则对网站进行系统性抓取,其访问路径往往呈现出线性或层次性特点。例如,爬虫可能会从网站首页开始,依次访问各个栏目页面,再深入到具体的文章页面,形成一条较为固定的访问路径。而正常用户则会根据自己的兴趣和需求,随机点击不同的链接进行浏览。通过对网站流量日志中的访问路径进行分析,可以识别出不符合正常用户浏览习惯的路径,从而判断是否存在爬虫抓取行为。据统计,约 80% 的 AI 爬虫具有较为固定的访问路径模式,通过分析访问路径可以准确识别出这些爬虫。

• User-Agent 分析:尽管可以通过服务器配置对特定的 User-Agent 进行限制,但仍有一些 AI 爬虫会伪装成正常的浏览器 User-Agent。因此,需要对流量日志中的 User-Agent 进行进一步分析。一方面,可以检查 User-Agent 的格式和内容是否符合常见浏览器的标准,是否存在拼写错误、格式异常等情况;另一方面,可以结合访问频率和路径等其他因素,综合判断 User-Agent 的真实性。例如,若某一 User-Agent 表示为常见的浏览器,但其访问频率和路径却符合爬虫特征,那么很可能是伪装的爬虫。通过这种综合分析方法,可以识别出约 30% 的伪装爬虫。

• IP 地址分析:分析访问网站的 IP 地址来源也是识别抓取行为的重要手段。一些 AI 爬虫可能会使用特定的 IP 地址或 IP 段进行抓取,通过对流量日志中的 IP 地址进行统计和分析,可以发现这些异常 IP。例如,若某一 IP 地址频繁出现在流量日志中,且其访问行为符合爬虫特征,可以将其列入黑名单,阻止其继续访问网站。此外,还可以结合 IP 地理位置信息,判断 IP 地址是否来自合理的地理位置范围。如果发现来自某些异常地区或与网站目标用户群体不符的 IP 地址频繁访问,也需要引起警惕。据统计,通过 IP 地址分析可以识别出约 20% 的恶意爬虫。

5.2 应对内容被盗用

当发现网站内容被 AI 平台抓取并用于商业用途或未经授权的传播时,需要及时采取有效的应对措施,以维护网站的合法权益。

• 发送警告函:在发现侵权行为后,第一时间向侵权的 AI 平台发送警告函,明确指出其抓取和使用网站内容的行为已构成侵权,要求其立即停止侵权行为,并删除已抓取的内容。警告函应详细说明侵权事实、法律依据以及要求对方采取的具体措施,如停止抓取、删除内容、赔偿损失等。据调查,约 60% 的侵权行为在收到警告函后会得到及时处理,因为侵权方为了避免法律纠纷,通常会选择主动配合。

• 法律诉讼:如果侵权方在收到警告函后仍然拒不配合,继续实施侵权行为,那么可以考虑通过法律诉讼来维护自身权益。在诉讼过程中,需要准备好充分的证据,如网站版权声明、侵权内容的截图、流量日志记录等,以证明侵权行为的存在和侵权方的过错。法律诉讼不仅可以要求侵权方停止侵权行为、删除侵权内容,还可以要求其赔偿因侵权行为给网站造成的经济损失,包括直接损失和间接损失,如流量下降、用户流失、品牌形象受损等。据统计,通过法律诉讼,网站可以获得侵权赔偿的比例约为 70% – 80%,这在一定程度上可以弥补因侵权行为造成的损失。

• 技术反制措施:除了法律手段外,还可以采取技术反制措施来应对内容被盗用。例如,可以对侵权平台进行技术封锁,禁止其 IP 地址或 User-Agent 访问网站;或者对侵权内容进行加密处理,使其无法正常使用。同时,可以利用数字水印技术,在网站内容中嵌入不可见的水印,当侵权内容被传播时,可以通过水印追踪侵权来源,为维权提供有力证据。据实验数据,采用技术反制措施后,侵权行为的再次发生率可以降低 40% – 50%,有效遏制了侵权行为的蔓延。

• 与平台协商合作:在一些情况下,也可以尝试与 AI 平台进行协商合作,寻找互利共赢的解决方案。例如,可以与平台签订授权协议,允许其在一定范围内合理使用网站内容,但需要支付相应的授权费用,并明确使用范围和方式。通过协商合作,不仅可以解决侵权问题,还可以为网站带来额外的收入,同时也可以借助 AI 平台的资源和渠道,扩大网站的影响力。据统计,通过协商合作解决侵权问题的成功率约为 30% – 40%,这种合作模式在一些大型 AI 平台和内容创作者之间较为常见。

6. 总结

在当今数字化时代,网站内容面临着来自 AI 平台的抓取挑战。通过本报告的详细分析,我们可以看到,网站运营者可以通过多种策略来有效保护网站内容,防止未经授权的抓取行为。

从技术手段来看,robots.txt 文件、服务器访问限制、动态加载内容和验证码验证等方法,能够从不同角度增加 AI 爬虫的抓取难度。其中,robots.txt 文件虽然简单,但能有效阻止遵守规则的爬虫;服务器访问限制通过 IP 地址和 User-Agent 过滤,可拦截大量已知爬虫;动态加载内容和验证码验证则进一步提升了抓取难度,使 AI 爬虫难以获取完整内容。

网站结构优化同样重要。动态加载内容和内容混淆处理不仅能够抵御 AI 平台抓取,还能在一定程度上保护网站的核心内容。动态加载内容通过分批次加载,使 AI 爬虫难以一次性获取完整页面;内容混淆处理则通过加密、编码和变形,使 AI 爬虫难以直接解析有效信息。

法律手段是网站内容保护的重要保障。发布版权声明和建立举报机制,能够有效警示侵权者并发动用户参与保护。版权声明明确版权归属和使用规则,减少侵权行为的发生;举报机制则通过用户的力量,及时发现和处理侵权行为。

监控与应对措施是保护网站内容的最后防线。分析流量日志能够及时识别 AI 平台的抓取行为,通过对访问频率、路径、User-Agent 和 IP 地址的分析,可以精准识别爬虫并采取相应措施。当内容被盗用时,发送警告函、法律诉讼、技术反制措施和与平台协商合作等方法,能够有效维护网站的合法权益。

综上所述,网站运营者需要综合运用技术手段、网站结构优化、法律手段和监控与应对措施,形成全方位的保护体系,以应对 AI 平台抓取网站内容的挑战。

最近文章

如何判断站点是否已经进入系统依赖阶段 在 AI 搜索环境中,站点的发展存在一个重要分水岭。 [...]

整站内容如何形成长期不可替代性 在 AI 搜索时代,“不可替代性”已经不再是一个抽象的品牌概念。 [...]

如何设计整站级的答案供给架构 当内容开始被 AI 使用,站点面临的已经不再是排名问题,而是一个更本质的问题: [...]